贝叶斯的性质

关键概念

联合概率:X取值为x和Y取值为y两个事件同时发生的概率,表示为P(X=x,Y=y)

条件概率:在X取值为x的前提下,Y取值为y的概率。表示为P(Y=y|X=x)

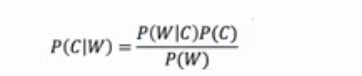

这里的C代表类别,W代表特征。

我们学习的其它分类算法总是有一个特点:这些算法先从训练集中学习,获取某种信息来建立模型,然后用模型去对测试集进行预测。比如逻辑回归,我们要先从训练集中获取让损失函数最小的参数,然后用参数建立模型,再对测试集进行预测。在比如支持向量机,我们要先从训练集中获取让边际最大的决策边界,然后 用决策边界对测试集进行预测。相同的流程在决策树,随机森林中也出现,我们在fit的时候必然已经构造好了能够让对测试集进行判断的模型。而朴素贝叶斯,似乎没有这个过程。这说明,朴素贝叶斯是一个不建模的算法。以往我们学的不建模算法,比如KMeans,比如PCA,都是无监督学习,而朴素贝叶斯是第一个有监督的,不建模的分类算法。我们认为,训练集和测试集都来自于同一个不可获得的大样本下,并且这个大样本下的各种属性所表现出来的规律应当是一致的,因此训练集上计算出来的各种概率,可以直接放到测试集上来使用。即便不建模,也可以完成分类。

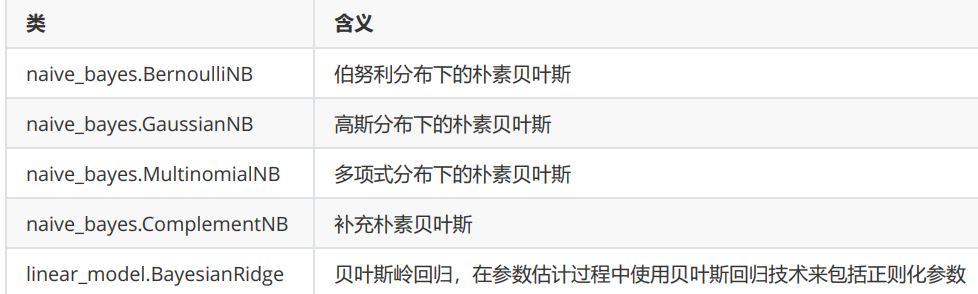

sklearn中的朴素贝叶斯

sklearn中,基于高斯分布、伯努利分布、多项式分布为我们提供了四个朴素贝叶斯的分类器

高斯朴素贝叶斯

sklearnnaive_bayes.GaussianNB(priors=None,var_smoothing=1e-09)

高斯朴素贝叶斯,通过假设P(Xi|Y)是服从高斯分布(正态分布),估计每个特征下每个类别上的条件概率。对于每个特征下的取值,有以下公式:

1 | from sklearn.naive_bayes import GaussianNB |

概率类模型的评估指标

布里尔分数Brier Score

概率预测的准确程度被称为“校准程度”,是衡量算法预测出的概率和真实结果的差异的一种方式。一种比较常用的指标叫做布里尔分数,它被计算为是概率预测相对于测试样本的均方误差,表示为:

其中N是样本数量,Pi为朴素贝叶斯预测出的概率,Oi是样本所对应的真实结果,只能取到0或者1,如果事件发生则为1,如果不发生则为0。这个指标衡量了我们的概率距离真实标签结果的差异,其实看起来非常像是均方误差。布里尔分数的范围是从0到1,分数越高则预测结果越差劲,校准程度越差,因此布里尔分数越接近0越好。由于它的本质也是在衡量一种损失,所以在sklearn当中,布里尔得分被命名为brier_score_loss。我们可以从模块metrics中导入这个分数来衡量我们的模型评估结果:

1 | #接上面的代码 |

对数似然函数

另一种常用的概率损失衡量是对数损失(log_loss),又叫做对数似然,逻辑损失或者交叉熵损失。由于是损失,因此对数似然函数的取值越小,则证明概率估计越准确,模型越理想。值得注意得是,对数损失只能用于评估分类型模型

在sklearn,我们可以从metrics模块中导入我们的对数似然函数:

1 | from sklearn.metrics import log_loss |

第一个参数是真实标签,第二个参数是我们预测的概率。真正的概率必须要以接口predict_proba来调用,千万避免混淆。

那什么时候使用对数似然,什么时候使用布里尔分数?

可靠性曲线

可靠性曲线(reliability curve),又叫做概率校准曲线(probability calibration curve),可靠性图(reliability

diagrams),这是一条以预测概率为横坐标,真实标签为纵坐标的曲线。我们希望预测概率和真实值越接近越好,

最好两者相等,因此一个模型/算法的概率校准曲线越靠近对角线越好。

1 | import matplotlib.pyplot as plt |

为什么存在这么多上下穿梭的直线?因为我们是按照预测概率的顺序进行排序的,而预测概率从0开始到1的过程中,真实取值不断在0和1之间变化,而我们是绘制折线图,因此无数个纵坐标分布在0和1的被链接起来了,所以看起来如此混乱。那我们换成散点图来试试看呢?

1 | #接上面的代码 |

可以看到,由于真实标签是0和1,所以所有的点都在y=1和y=0这两条直线上分布,这完全不是我们希望看到的图像。回想一下我们的可靠性曲线的横纵坐标:横坐标是预测概率,而纵坐标是真实值,我们希望预测概率很靠近真实值,那我们的真实取值必然也需要是一个概率才可以,如果使用真实标签,那我们绘制出来的图像完全是没有意义的。但是,我们去哪里寻找真实值的概率呢?这是不可能找到的——如果我们能够找到真实的概率,那我们何必还用算法来估计概率呢,直接去获取真实的概率不就好了么?所以真实概率在现实中是不可获得的。但是,我们可以获得类概率的指标来帮助我们进行校准。一个简单的做法是,将数据进行分箱,然后规定每个箱子中真实的少数类所占的比例为这个箱上的真实概率trueproba,这个箱子中预测概率的均值为这个箱子的预测概率predproba,然后以trueproba为纵坐标,predproba为横坐标,来绘制我们的可靠性曲线。

在sklearn中,这样的做法可以通过绘制可靠性曲线的类calibration_curve来实现。和ROC曲线类似,类calibration_curve可以帮助我们获取我们的横纵坐标,然后使用matplotlib来绘制图像。该类有如下参数:

1 | #接上面的代码 |

根据不同的n_bins取值得出不同的曲线

1 | #接上面的代码 |

很明显可以看出,n_bins越大,箱子越多,概率校准曲线就越精确,但是太过精确的曲线不够平滑,无法和我们希望的完美概率密度曲线相比较。n_bins越小,箱子越少,概率校准曲线就越粗糙,虽然靠近完美概率密度曲线,但是无法真实地展现模型概率预测地结果。因此我们需要取一个既不是太大,也不是太小的箱子个数,让概率校准曲线既不是太精确,也不是太粗糙,而是一条相对平滑,又可以反应出模型对概率预测的趋势的曲线。通常来说,建议先试试看箱子数等于10的情况。箱子的数目越大,所需要的样本量也越多,否则曲线就会太过精确。

校准可靠性曲线

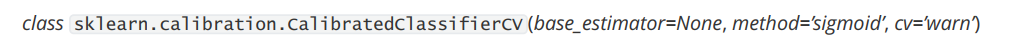

sklearn中的概率校正类CalibratedClassifierCV来对二分类情况下的数据集进行概率校正

base_estimator

需要校准其输出决策功能的分类器,必须存在predict_proba或decision_function接口。 如果参数cv = prefit,分类

器必须已经拟合数据完毕。

cv

整数,确定交叉验证的策略。可能输入是:

None,表示使用默认的3折交叉验证。在版本0.20中更改:在0.22版本中输入“None”,将由使用3折交叉验证改为5折交叉验证

任意整数,指定折数对于输入整数和None的情况下来说,如果时二分类,则自动使用类sklearn.model_selection.StratifiedKFold进行折数分割。如果y是连续型变量,则使用sklearn.model_selection.KFold进行分割。

已经使用其他类建好的交叉验证模式或生成器cv。

可迭代的,已经分割完毕的测试集和训练集索引数组。

输入”prefit”,则假设已经在分类器上拟合完毕数据。在这种模式下,使用者必须手动确定用来拟合分类器的数

据与即将倍校准的数据没有交集

method

进行概率校准的方法,可输入”sigmoid”或者”isotonic”

输入’sigmoid’,使用基于Platt的Sigmoid模型来进行校准

输入’isotonic’,使用等渗回归来进行校准

当校准的样本量太少(比如,小于等于1000个测试样本)的时候,不建议使用等渗回归,因为它倾向于过拟合。样

本量过少时请使用sigmoids,即Platt校准。

1 | import matplotlib.pyplot as plt |

多项式朴素贝叶斯

在sklearn中,用来执行多项式朴素贝叶斯的类MultinomialNB包含如下的参数和属性:

1 | from sklearn.preprocessing import MinMaxScaler |

其实效果不是很理想,来试试看把Xtrain转换成分类型数据吧。注意我们的Xtrain没有经过归一化,因为做哑变量之后自然所有的数据就不会又负数了。看下面的代码:

1 | from sklearn.preprocessing import KBinsDiscretizer |

伯努利朴素贝叶斯

1 | from sklearn.preprocessing import MinMaxScaler |

补集朴素贝叶斯

在sklearn中,补集朴素贝叶斯由类ComplementNB完成,它包含的参数和多项式贝叶斯也非常相似: